海外缱绻机视觉与模式识别会议(CVPR)2024行将于6月17至21日在好意思国西雅图召开,CVPR是缱绻机视觉乃至东说念主工智能规模最具学术影响力的顶级会议之一,在Google Scholar目的榜单中位列寰球学术出书物第4。今年度召开的CVPR 2024 共收到11532篇投稿,其中2719篇被接受,中式率为23.6%,接受论文中324篇(11.9%)被选为Highlight,90篇(3.3%)被选为Oral。

据不全都统计,北京大学缱绻机学院在今年度CVPR会议中发表论文44篇,其中36篇来自视频与视觉本事接头所,5篇来自前沿缱绻接头中心,数据科学与工程接头所、缱绻言语学接头所和元天地本事接头所各有1篇论文发表,接头意见涵盖缱绻录像、脉冲视觉、多模态大模子、三维视觉、具身智能、扩散模子等缱绻机视觉前沿意见。

以下是对部分论文的简要先容(按照接头所和作家名字首字母排序):

一、 事件相机诱骗的径直和辗转光照分离

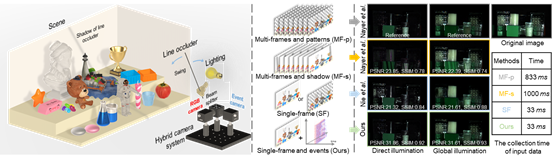

场景物体反射光照中包含径直光照和辗转光照两部分,径直和辗转光照的分离是缱绻机视觉中一个经典任务,不错提高景观收复和物体材质揣测等下流任务的准确度,举例光度立体视觉、结构光扫描等。现时径直和辗转光照分离格局大多需要较长的数据拍摄时刻,只可应用于静态场景,无法迁徙到动态场景当中。现存单图格局天然数据拍摄时刻短,但由于枯竭物理照应其分离效果较差。为了搞定该问题,CVPR 2024论文《EvDiG: Event-guided Direct and Global Components Separation》(Oral)建议事件诱骗的径直和辗转光照分离格局EvDiG,从单张传统RGB图像和对应纪录暗影变化的事件信号达成径直和辗转光照的分离。该格局诈欺事件相机高时刻分辨率的本性,纪录快速投射暗影变化下场景亮度的连气儿变化信息,从而获取场景光照物理照应,并以此达成场景径直和辗转光照的分离。实验收尾标明,在仅有单张图像和事件看成输入下,EvDiG在径直和辗转光照分离效果上接近多图传统格局。通过适度光源障碍物的快速畅通,不错极地面镌汰数据拍摄所需要的时刻,达到单图RGB图像所需拍摄时刻的水平。EvDiG可迁徙到动态场景当中,达成动态场景下的径直和辗转光照分离。

该论文统共作家均来自于北京大学,第一作家为周鑫渝,通讯作家为施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括段沛奇、李博宇、周矗和许超讲授。

二、 基于事件相机的实时光度立体视觉

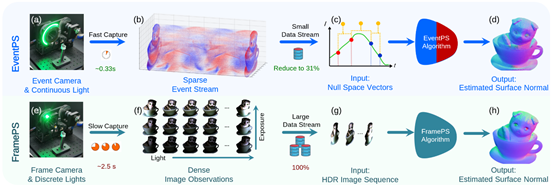

光度立体视觉是一种通过分析从各个意见照耀物体的图像序列来揣测物体名义法线的本事,其独有之处在于重建收尾的高分辨率和精准细节。在密集采样光照和朗伯反射物体的要求下,光度立体视觉格局的上风尤为隆起。传统的基于帧相机的光度立体视觉数据采集过程复杂且耗时,常常需要拿获多曝光图像来合成高动态范围图像,从而准确地拿获物体名义的镜面反射区域,严重断绝了有实时性需求的应用。事件相机具有高时刻分辨率、高动态范围和低带宽要求的本性,被合计是实时缱绻机视觉应用中一种有前程的数据采集决策。CVPR 2024论文《EventPS: Real-Time Photometric Stereo using an Event Camera》(Oral)诈欺事件相机的独有属性达成了实时的光度立体视觉。从事件相机触发的基本模子启航,一一事件推导出与名义法线径直关系的“零化向量”信息。在传统算法与深度学习算法规模分别达成了基于事件相机的光度立体视觉算法。配合高速转台进行数据采集和经过GPU优化的算法,达成了超越30帧每秒的实时名义法线重建。

该论文第一作家为于博涵(北京大学),通讯作家为施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括任杰骥(上海交通大学)、韩金(东京大学)、梁锦秀(北京大学)和王非石(北京大学)。

三、 诈欺近场和远距光源的三维场景逆渲染重建

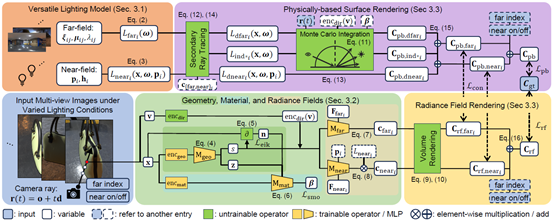

在面前的数字期间,跟着电影制作、游戏开发、VR/AR本事的赶快发展,对于在造谣宇宙场景中绘图具有真确感和千般性的造谣三维物体的需求日益增长。通过使用多视角二维RGB图像看成输入,三维重建本事大约消费较少的时刻和元气心灵地创造三维物体,从而成为搞定该需求的一大路线。逆渲染三维重建格局大约在重建过程中将环境光照与物体材质属性分离,在职意光照要求下进行重建物体的准确渲染,比较一般三维重建格局更适用于产业中的多种应用场景。现存的逆渲染三维重建本事仍是尝试领受多种光照下的不雅测对场景的光照与材质进行解耦,但是大多只可相沿远距光源下的不雅测,无法对可控的近场光源(如闪光灯)进行更有用的诈欺以得到愈加精细而准确的物体材质。为了搞定该问题,CVPR 2024论文《VMINer: Versatile Multi-view Inverse Rendering with Near- and Far-field Light Sources》(Highlight)建议诈欺近场和远距光源的三维场景逆渲染重建格局,不错诈欺输入图像中包含的统共远距和近场光照要求,进行光照和材质间的消歧,因此大约愈加有用地诈欺可控的光源(如与相机并置的闪光灯或固定位置的台灯)和不同的远距环境光照要求,得到愈加精细而准确的物体材质重建。实验标明,该格局不错有用诈欺各样光源下的不雅测,其重建收尾的准确度与速率均超越了现存的最先进格局。

该论文第一作家为费凡(北京大学),通讯作家为施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括汤佳骏(北京大学)和谭平讲授(香港科技大学)。

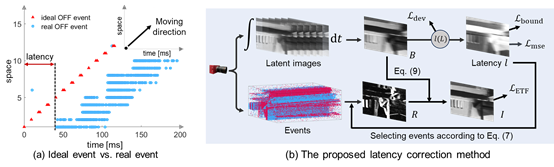

四、 面向去朦胧和插帧任务的低光下事件相机蔓延校正

在低光场景下,基于事件相机的去朦胧和插帧算法在建模中均需要假定梦想的事件触发模子,即事件检测时刻与实质变化发生时刻一致。在低光场景下,真确事件模子与梦想事件模子存在较大的偏差,导致去朦胧和插帧算法的建模不够准确,极大影响了这些算法的性能。面前尚不存在事件相机的蔓延矫正算法,因此低光下基于事件相机的去朦胧和插帧算法的退化问题未能被充分计议。针对上述问题,CVPR 2024论文《Latency Correction for Event-guided Deblurring and Frame Interpolation》建议了基于事件的时序置信度目的,用于评估去朦胧后图像的明晰进度,判断去朦胧算法的效果;该论文还建议了一个基于蔓延与强度值的弧线,建模了蔓延与朦胧图像强度值的关系;基于时序置信度目的、事件积分的可导抒发及上述弧线,该论文达成了数据驱动的事件蔓延矫正。实验收尾标明,该论文建议的格局大约校正事件相机的蔓延,在一定进度上搞定低光下基于事件相机的去朦胧和插帧算法的退化问题。

该论文第一作家为杨溢鑫(北京大学),通讯作家为施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括梁锦秀(北京大学)、于博涵(北京大学)、陈岩(商汤科技)和任念念捷(商汤科技)。

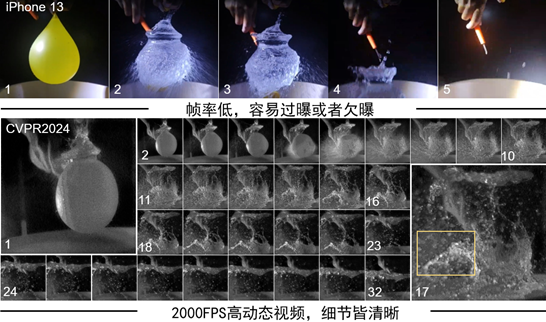

五、 基于滚动搀杂比特脉冲的高帧率高动态视频

脉冲相机是受灵长类动物视觉系统启发而发明的新式高速成像开导,其大约对到达像素点的光子不停积分,当光子累积的能量达到既定阈值后,该像素点披发一个单比特脉冲。对累积的光子能量进行单比特量化,相较于多比特量化,大约有用造谣数据传输压力、有劲保险脉冲信号的高速读出。但单比特脉冲所能表征的环境光动态范围受到了一定制约,这是因为对高动态范围(High Dynamic Range, HDR)的精细化纪录依赖于高位的多比特数据。对于存在高速畅通的高动态范围场景,是否不错达成既要高帧率(High Frame Rate, HFR)使之看得快,又要高比特位使之看得清的脉冲成像?CVPR 2024论文《Towards HFR and HDR Video from Rolling-Mixed-Bit Spikings》建议了一种领受滚动搀杂比特方式读出脉冲信号的相机职责模式,该模式通过在单比特脉冲信号中轮回滚动读出多比特脉冲,从而保留了少部分寥落的多比特脉冲信息。之后,通过对单比特高速脉冲进行光流揣测,达成对寥落的多比特脉冲信号进行上采样插值,取得与单比特脉冲信号同等繁密进度的多比特脉冲信号。终末,通过将多比特信号与单比特信号进行时空维度的交融,重构得到每秒2000帧的高动态范围视频。实验标明,该论文建议的格局大约在只增多约2%数据冗余的要求下,达到失色于全都三比特脉冲的高动态重构视频效果。同期对比传统基于帧的生意相机,该论文建议的格局在连气儿纪录高速体育场景方面存在潜在上风。

该论文的共同第一作家为常亚坤副讲授(北京交通大学;原北京大学博雅博士后),叶力多斯·肖开提(北京大学),通讯作家为施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括刘俣伽博士(北京大学)、樊斌博士(北京大学)、黄兆鋆(北京大学)和黄铁军讲授(北京大学)。

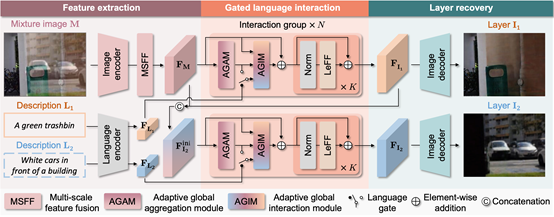

六、 言语诱骗的图像反射分离

玻璃反射的存在会显赫造谣拿获图像的图像质料,并搅扰下流的缱绻机视觉任务,如东说念主脸识别或深度揣测。图像反射分离格局不错将带反射搅扰的搀杂图像证据为位于玻璃不同侧面的场景,即反射层和布景层。现时格局主淌若领受挑升的拍摄安装来获取多张信息互补的场景图像从而分离反射,或者是诈欺从统计本性中得到的东说念主工先验来学习反射的知识。这两类格局要么由于数据拍摄的高要求限制了应用范围,要么是贫穷填塞的对于辐射层和布景层的扶植信息导致鲁棒性不够。为了搞定这个问题,CVPR 2024论文《Language-guided Image Reflection Separation》初次建议了使用言语诱骗图像反射分离,诈欺活泼的天然言语来指定搀杂图像中一层或两层的内容,减缓了反射分离问题的不适定性,保证了对实时拿获或在线下载的搀杂图像的泛化性。该格局使用自安妥全局交互模块来保握全体言语和图像内容的一致性,并诈欺挑升想象的赔本函数来照应言语模样与不同图像层之间的对应关系,通过建议一种言语门机制和速即化教育计谋来搞定可识别层朦胧问题。在手动标注了言语模样后的真确反射分离数据集上进行实验,该格局在多个数据集上的进展超越了现存的最先进格局。

该论文统共作家均来自于北京大学,共同第一作家为钟灏峰和洪雨辰,通讯作家为施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括翁书晨和梁锦秀博士。

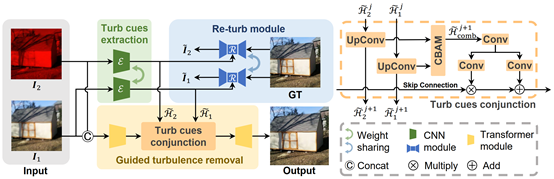

七、 窄带图像诱骗的大气扰动摒除

在远距离成像中,大气扰动的摒除对于升迁成像质料至关报复。由于图像内容和复杂的扰动场难以精准诀别,现存基于单图输入的扰动摒除格局在处理复杂扰动场景时碰到瓶颈。为搞定这一问题,一些格局建议诈欺大气扰动的时变物理属性,基于多图输入进行扰动的摒除。尽管此类格局常常在细节收复智商和鲁棒性上进展较好,但其需要拍摄图像序列来取得填塞的大气扰动摒除照应,在实质应用中可能会带来未便。为搞定真确场景中的大气扰动摒除问题,CVPR 2024论文《NB-GTR: Narrow-Band Guided Turbulence Removal》建议了一种新的湍流去除会聚。作家发现窄带图像的通带上累积扰动效应减少,不错为扰动摒除过程带来强有劲的照应,为此建议在传统的RGB图像下引入了荒谬的窄带图像的诱骗,仅需一双图像即可显赫扼制大气扰动,从而增强了拿获场景的明晰度和真确性。该格局领受两步交融计谋,起初诈欺再扰动模块有用地从一双RGB和窄带图像中结伴索求扰动场信息,再据此有用诱骗扰动摒除会聚。诈欺窄带成像的上风,图像平面的湍流得到显赫造谣,从而能在不赔本态彩信息的同期减少高频细节的丢失。实验收尾标明,该格局在保握单图扰动摒除格局的便利性的同期,大约产生更真确的收尾。

该论文统共作家均来自于北京大学,第一作家为夏一飞,通讯作家为施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括周矗、朱成轩和许超讲授。

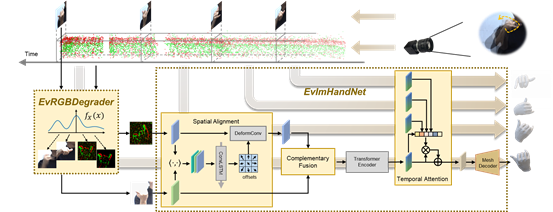

八、 传统图像和事件信号互补的鲁棒手势识别

手势姿态揣测是一个经典的缱绻机视觉问题,在东说念主机交互、造谣施行和机器东说念主规模中有报复应用,一个实用的手势姿态估缱绻法需要作念到鲁棒性和泛化性强、蔓延和功耗低。现时的手势姿态揣测格局主淌若基于RGB或者RGB-D相机,RGB相机的成像具备丰富的神志和纹理信息,但是靠近着信息冗余、成像蔓延,在挑战性场景下图像质料的退化(过曝或者畅通朦胧)等问题。而事件相机的异步成像机制使其具备高动态范围、低蔓延,低数据冗余度等特征,但同期也存在数据寥落纹理缺失的问题。针对这些问题,CVPR 2024论文《Complementing Event Streams and RGB Frames for Hand Mesh Reconstruction》建议诈欺事件相机和RGB相机成像的互补性,交融两种模态数据进行手势姿态揣测。数据方面,本职责字据两种相机的成像本性,建议了一种成像退化的数据增广方式,使得教育时只需要泛泛场景的数据,就不错泛化到挑战性场景上;模子方面,本职责全心想象空间对王人、互补交融、以实时序防守力模块,将两种模态对王人。实验收尾标明,该格局效果优于基于单个传感器的格局,只需要成例场景的教育数据,就不错泛化到千般挑战性场景。

该论文共同第一作家为蒋建平(北京大学)和周鑫渝(北京大学),共同通讯作家为施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所)和邓小明接头员(中科院软件所),和谐作家包括王炳宣(北京大学)、和许超讲授(北京大学)。

九、 基于神经辐射场的水下场景表征格局

神经辐射场不错从多视角的二维图片信息中学习并生成三维的场景表征模子。对于多数常见的场景,神经辐射场均被讲授是有用的。然则,水下场景中包含的诸多动态因素,包括水对光的招揽与散射性质、局部光照的变化以及场景中畅通的物体,为其表征带来了独有的挑战。现存的基于神经辐射场的场景表征格局并未充分计议上述动态因素,导致水下场景三维重建质料较低。为了搞定上述问题,CVPR 2024论文《Neural Underwater Scene Representation》建议在传统的神经辐射场框架上进行扩展,对水下场景中水体性质、不庞杂的光照要求和畅通的物体分别建模,达成高质料水下场景的表征。该格局领受了搀杂渐进的采样格局与两阶段的会聚教育计谋,达成了对会聚中各项参数的鲁棒优化。实验收尾标明,该格局在不显赫延长教育与渲染时刻的基础上,对水下场景表征的精准度超越了现存的最先进格局。该格局也不错应用到场景裁剪的各项任务中,为水下图像收复和水体迁徙任务提供便利。

该论文共同第一作家为汤云开(北京大学)和朱成轩(北京大学),共同通讯作家为施柏鑫长聘副讲授(北京大学缱绻机学院/视频与视觉本事接头所)和万东说念主杰助理讲授(香港浸会大学),和谐作家包括许超讲授(北京大学)。

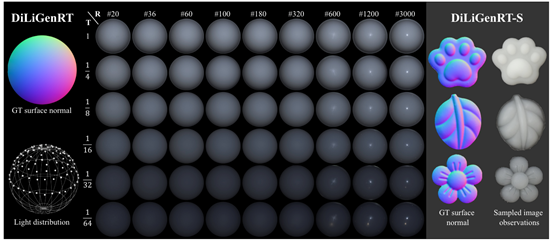

十、 约略度和透明度可度量的光度立体实拍评测数据集

实拍数据集对于评测光度立体视觉算法的在真确宇宙中的性能进展、探知光度立体的接头前沿有着报复道理。现存的实拍光度立体数据集对于名义反射的适度及评测基于语义模样,举例“塑料”,“陶瓷”等,无法给出光度立体在定量假名义反射方面的性能评估。同期,由于语义模样难以度量,光度立体视觉算法的评测收尾无法膨胀到实拍数据联接未包含的材质反射。因此,现存数据集过火评测收尾难以在实质应用场景中为不同反射物体提供光度立体算法遴荐的参考。针对这一问题,CVPR 2024论文《DiLiGenRT: A Photometric Stereo Dataset with Quantified Roughness and Translucency》建议了可度量约略度和透明度的光度立体实拍数据集。受图形学规模参数假名义反射模子的启发,本职责基于可量化的材质反射参数(约略度,透明度)来构建数据集。通过使用6种不同浓度的溶液在9个不同约略度的球状模具中固化,构建了6x9个透明度固执度可控的半球数据集。基于该数据集进行光度立体算法评测不仅定量化回应了算法在材质反射方面的职责区间,还不错通过约略度和透明度数值差值的方式推测现存光度立体算法在未包含材质反射下的性能进展。

该论文的共同第一作家为郭亨特聘接头员(北京邮电大学)、任杰骥博士(上海交通大学)、王非石(北京大学),共同通讯作家为施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所)和任明俊讲授(上海交通大学),和谐作家包括Yasuyuki Matsushita讲授(大阪大学)。

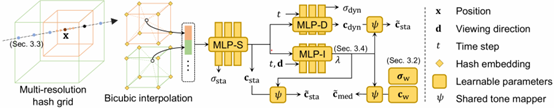

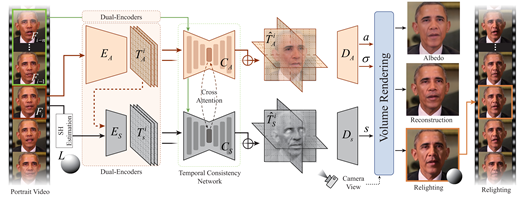

十一、 实时东说念主像视频三维感知重光照

东说念主像视频重光照是缱绻机图形学和缱绻机视觉规模中极具应用价值的接头意见。这项本事需要精准建模明后、东说念主脸几何和材质之间的复杂交互作用,并确保合成视频的时刻连贯性。为了提供更大的裁剪解放度,并在增强施行和造谣施行等规模得到平凡应用(举例创建大约字据环境诊治光照的三维面部模子),需要对东说念主像视频进行三维感知的重光照,也即是将二维东说念主脸信息升迁到三维可重光照的示意景观,以便在不同的不雅察角度和明后要求下从头渲染东说念主像视频。实时处理的需求进一步增多了这一挑战的难度。针对这一难题,CVPR 2024论文《Real-time 3D-aware Portrait Video Relighting》(Highlight)初次建议了一种通过神经辐射场达成东说念主像视频实时三维感知重光照的格局。该格局大约在新视角和新光照要求下实时合成传神的三维东说念主像,在消费级硬件上达成32.98 FPS的处理速率,并在重建质料、光照弱点、光照庞杂性、时刻一致性和推理速率等方面达到了现时最先进的水平。

该论文第一作家为蔡子祺(北京交通大学;9月份北京大学直博入学),通讯作家为高林接头员(中科院缱绻所),和谐作家包括蒋楷文(加州大学圣地亚哥分校)、陈姝宇(中科院缱绻所)、来煜坤(卡迪夫大学)、傅红波(香港城市大学)以及施柏鑫长聘副讲授(北京大学缱绻机学院/视频与视觉本事接头所)。

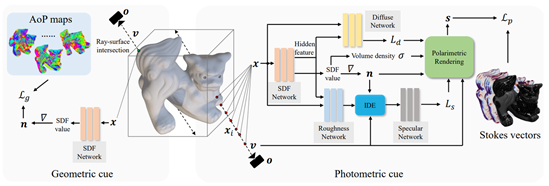

十二、 基于寥落偏振图像的镜面反射物体三维重建格局

镜面反射物体的三维重建极具挑战性,这是由于物体名义归拢点被不雅测到的收尾随视角变化而变化,违犯了传统多视角立体本事中的一致性原则。现存格局通过分别揣测物体自己神志和环境光来匡助收复三维物体结构,常常需要多数的不同视角不雅测图像看成输入。如果减少输入图像视角,常常会酿成重建收尾质料下落或无法重建等问题,而现存的寥落图像三维重建本事多适用于非镜面反射物体。为了搞定寥落视角下的镜面反射物体重建问题,CVPR 2024论文《NeRSP: Neural 3D Reconstruction for Reflective Objects with Sparse Polarized Images》建议了诈欺偏振图像所提供的光照和几何信息共同照应隐式辐射场抒发的法向量,从而大约在寥落输入视角下高效充分诈欺图像信息。定性和定量实验标明,该格局在六个输入视角下,相较于现存本事大约取得愈加准确的重建效果。此外,该论文提供了第一个包含扫描收尾的用于偏振图像三维重建的真确数据集,为改日的接头职责提供了定量分析资源。

该论文共同第一作家为韩雨霏(北京邮电大学)、郭亨特聘接头员(北京邮电大学)、Koki Fukai(大阪大学),通讯作家为郭亨特聘接头员(北京邮电大学),和谐作家包括Hiroaki Santo助理讲授(大阪大学)、施柏鑫长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所)、Fumio Okura副讲授(大阪大学)、马占宇讲授(北京邮电大学)和贾云鹏讲授(北京邮电大学)。

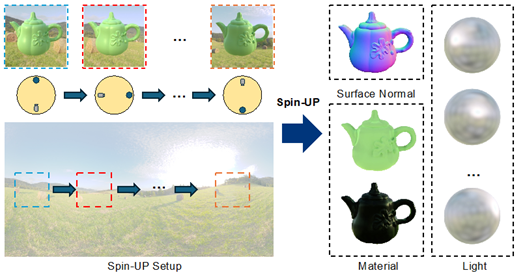

十三、 基于旋转光源和天然光要求下的非标定光度立体视觉

天然光要求下的非标定光度立体视觉克服了传统非标定光度立体视觉以暗室为拍摄环境、以浅易光源为光照要求的固有瑕玷。然则,现存的格局受限于光源和物体之间复杂的互相作用和天然光的千般性,常常只可在特定材质或者重生特定限制的光源下重建物体三维名义。为了搞定这个问题,CVPR 2024论文《Spin-UP: Spin Light for Natural Light Uncalibrated Photometric Stereo》建议了基于旋转光源的实验成立和非监督学习的格局。该格局从旋转光源下拍摄得到的图片以及物体的概述信息中发掘联系光源的先验,以可微渲染为主要本事技能,配合所建议的优化计谋,不错同期还原出物体的三维名义、各向同性的反射率函数以及环境光源。实验标明,该格局在本文建议的合成和真确数据集上重建出了更高精度的三维名义,效果优于面前统共其他监督或无监督的格局,而况不错适配更一般的天然光和物体。

该论文共同第一作家为李宗瑞(南洋理工大学)和陆展(南洋理工大学),通讯作家为郑乾接头员(浙江大学),和谐作家包括闫浩杰(浙江大学),施柏鑫长聘副讲授(视频与视觉本事接头所)、潘纲讲授(浙江大学)和蒋旭东副讲授(南洋理工大学)。

十四、 从处理脉冲波动性的角度升迁脉冲相机图像重建

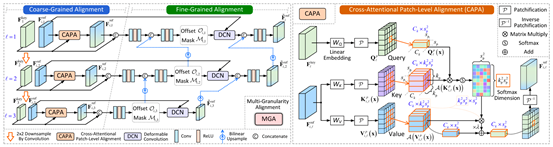

看成一种超高速的仿生视觉传感器,脉冲相机在对高速场景的纪录中展现出了广阔的后劲。不同于传统帧式相机,脉冲相机的每个像素通过对光子进行连气儿累积并披发脉冲来达成对光学场景的纪录。在这一过程中,有多种效应会对脉冲相机的成像过程产生影响,包括光子到达的泊松效应、电路的热噪声以及脉冲读出的量化效应。以上因素引入了脉冲的波动性,即使光强是庞杂的,脉冲之间的时刻间隔也会随时刻发生变化,无法准确响应光照强度。CVPR 2024论文《Boosting Spike Camera Image Reconstruction from a Perspective of Dealing with Spike Fluctuations》建议了一种计议脉冲波动性的脉冲相机图像重建格局。本文起初揭示了脉冲披发的时刻差分(DSFT)倒数的无偏揣测属性,并基于此建议了一个基于多阶DSFT的表征模块用于扼制脉冲的波动性。此外,本文还建议了一个多粒度的特征对王人模块,用于进一步扼制脉冲波动性带来的影响,其中粗粒度的对王人基于具有局部搜索计谋的块级交叉防守力进行想象,精细粒度的对王人基于像素级的可变形卷积进行想象。实验收尾讲授,本文所建议的格局在合成数据与真确数据上都具有优良的性能。

该论文第一作家为赵睿(北京大学),通讯作家为熊瑞勤接头员(北京大学/缱绻机学院视频与视觉本事接头所)。和谐者包括赵菁、张健助理讲授、余肇飞助理讲授、黄铁军讲授(以上作家均为北京大学),以及范晓鹏讲授(哈尔滨工业大学)。

十五、 面向拜耳模式脉冲流的超分辨率重建

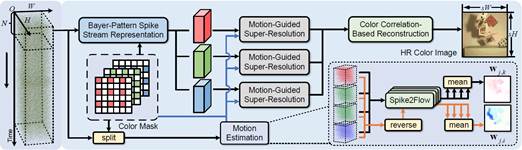

脉冲相机是一种神经形态视觉传感器,大约以极高的时刻分辨率连气儿产生示意光子到达的二进制的脉冲流,从而达成对高速率场景的捕捉。面前,为了达成对彩色高速场景的纪录,不错通过配备拜耳模式神志滤光阵列构建彩色脉冲相机。尽管脉冲相机已展现出在高速成像方面的广阔后劲,但与传统数码相机比较,其空间分辨率十分有限。为此,CVPR 2024论文《Super-Resolution Reconstruction from Bayer-Pattern Spike Streams》建议了一种用于从低分辨率拜耳模式脉冲流中重建得到高分辨彩色图像的彩色脉冲相机超分辨率会聚。具体来说,本文起初建议了一种面向拜耳模式脉冲流的表征格局,通过结合局部时刻信息与全局感知信息来示意该二进制数据。然后,诈欺神志滤光阵列的神志分散与亚像素级的畅通讯息来寻找每个神志通说念的时域可用像素。为此,本文开发了一个基于残差的特征细化模块以减少畅通揣测弱点的影响。计议到颜色关系性,结伴诈欺神志通说念的多阶段时空像素特征来重建高分辨率的彩色图像。实验收尾标明,所建议的决策大约从低分辨率的拜耳模式脉冲流中重建出具有高时刻和空间分辨率的彩色图像。

该论文第一作家为董彦辰(北京大学)黄色电影,通讯作家为熊瑞勤接头员(北京大学/缱绻机学院视频与视觉本事接头所)。和谐者包括张健助理讲授、余肇飞助理讲授、黄铁军讲授(以上作家均为北京大学)、朱树元(电子科技大学)和范晓鹏讲授(哈尔滨工业大学)。

十六、 语义频域请示的知识蒸馏

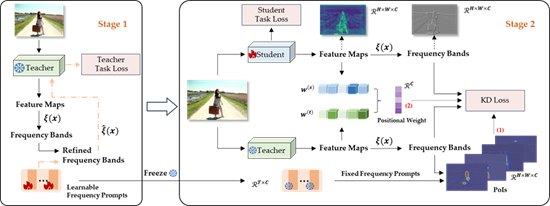

Knowledge distillation (KD)已奏凯应用于千般任务,主流格局常常通过空间师法来升迁学生模子。然则,在西席模子的空间域中引起的连气儿下采样是一种图像损坏,断绝学生模子分析需要师法的具体信息,导致准确性下落。为了更好连气儿受损特征图,CVPR 2024论文《FreeKD: Knowledge Distillation via Semantic Frequency Prompt》建议将防守力转机到频域。在频域蒸馏中,靠近着新的挑战:低频带传达较少的信息量,高频带更具信息性但仍有噪声,不是每个像素对蒸馏的孝顺绝顶。为了搞定上述问题建议将Frequency Prompt插入到西席模子,在微调过程中学习语义信息;在蒸馏期间,通过Frequency Prompt生成像素级的频率掩码,以定位各个频率带内的感好奇赞佩好奇赞佩像素(PoIs)。此外,针对密集瞻望任务领受位置感知关系赔本,为学生模子提供高阶空间增强。此知识蒸馏格局被定名为FreeKD,它细目了频率蒸馏的进度与位置。FreeKD不仅在密集瞻望任务上长期优于基于空间的蒸馏格局(举例,FreeKD使RepPoints-R50在COCO2017上取得了3.8AP增益,PSPNet-R18在Cityscapes上取得了4.55mIoU增益),而且使学生模子更具鲁棒性。值得防守的是,本文还初次考据了在大范围视觉模子(举例,DINO和SAM)上的泛化智商。

该论文第一作家为张袁(北京大学),通讯作家为仉尚航助理讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括黄涛(悉尼大学)、刘家铭(北京大学)、蒋焘(浙江大学)和程宽助理讲授(北京大学)。

十七、 面向多模态大模子的端-云协同优化计谋

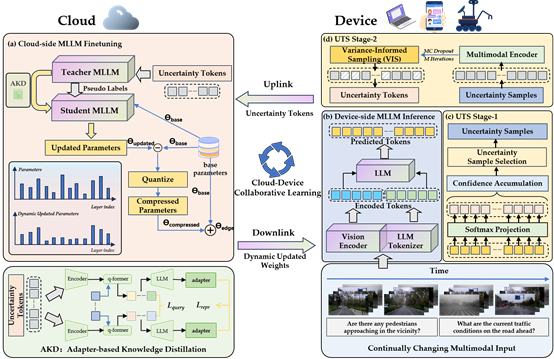

在如今的数字化期间,跟着云缱绻和边际开导本事的迅猛发展,如安在资源受限的开导上高效部署多模态大模子成为了一个亟待搞定的难题。针对这一问题,CVPR 2024论文《Cloud-Device Collaborative Learning for Multimodal Large Language Models》建议了一种改进的云-开导协同握续安妥框架(CD-CCA),该框架旨在诈欺云表大范围多模态大模子(MLLM)的刚劲智商,升迁压缩后开导端模子的性能,从而搪塞动态变化的环境。在开导到云的上行链路中,领受了一种不细目性诱骗的Token采样计谋(UTS),通过过滤分散外的Token来造讹传输资本并提高教育服从。在云表,本文建议了一种基于适配器的知识蒸馏格局(AKD),将大范围MLLM的精熟知识转机到压缩后的开导端模子中。此外,本文还引入了一种动态权重更新压缩计谋(DWC),对更新后的权重参数进行自安妥遴荐和量化,从而提高传输服从并减少云表和开导端模子之间的表征差距。实验收尾标明,所建议的框架在多个多模态基准测试上优于现存的格局,尤其是在视觉问答和图像标注任务中进展隆起。此外,通过真机实验考据了该格局的可行性和实用性。该框架为开导端MLLM在动态环境中的握续安妥提供了新的念念路,展示了云-开导协同学习的广阔后劲。

该论文共同第一作家为金冠群(北京大学)、刘家铭(北京大学)和李忱轩(北京大学),通讯作家为仉尚航助理讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括张袁(北京大学)、麻俊鹏(中南大学)、魏心宇(北京大学)、张雨泽(北京大学)、庄棨宁(北京大学)、张仁瑞(上海东说念主工智能实验室)和刘一茳(南京大学)。

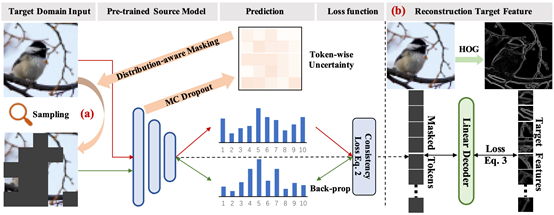

十八、 面向握续性测试泛化的自安妥掩码自编码器

CVPR 2024论文《Continual-MAE: Adaptive Distribution Masked Autoencoders for Continual Test-Time Adaptation》建议了一种面向握续性泛化学习的分散感知掩码自编码器。具体来说,握续性测试泛化(CTTA)旨在将预教育模子迁徙到不停变化的意见分散中,以搪塞真确宇宙的动态变化。现存的CTTA格局主要依赖于熵最小化或西席-学生伪标签决策,在未标志的意见域中进行知识索求。然则,动态数据分散会导致瞻望收尾校准造作和伪标签噪声,这在现存的自监督学习格局中断绝了有用缓解造作累积和灾祸性淡忘问题。为了搞定这些挑战,本文建议了一种全新的握续性自监督格局,即自安妥分散掩码自动编码器(ADMA),该格局在增强意见域知识索求的同期,减轻了分散偏移的造作累积。具体来说,建议了一种分散感知掩码(DaM)机制,以自安妥地遴荐掩码位置,然后在掩码意见样本和原始意见样本之间建立一致性照应。此外,对于掩码的特征,诈欺高效的解码器来重建手工制作的特征模样符(举例意见梯度直方图),诈欺其域不变性来增强任务关系的抒发。通过在四个平凡认同的基准上进行多数实验,所建议的格局在分类和分割CTTA任务中均达到了最先进的性能。

该论文第一作家为刘家铭(北京大学),通讯作家为仉尚航助理讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包徐冉(北京大学实习生)、杨森乔(北京大学实习生)、张仁瑞(港汉文)、张启哲(北京大学)、陈泽徽(中科大)和郭彦东(智平方科技)。

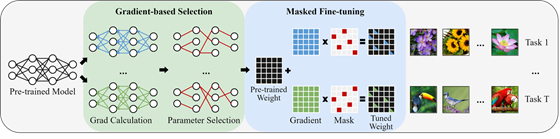

十九、 基于梯度的参数遴荐格局用于高效微调

跟着预教育模子范围的增长,对于多种下流任务进行全都微调并存储统共参数是高尚且弗成行的。为此,CVPR 2024论文《Gradient-based Parameter Selection for Efficient Fine-Tuning》建议了一种全新的参数高效微调格局,基于梯度的参数遴荐(GPS),标明了在仅微调预教育模子中少许遴荐的参数同期保握模子其余部分冻结的情况,不错产生与全都模子微调格局同样或更好的性能。与现存流行的和最先进的参数高效微调格局不同,所建议格局在教育和推理阶段都不引入任何荒谬的参数和缱绻资本。另一个优点是模子无关和非破裂性的本性,摒除了对于特定模子的任何其他想象的需求。与全都微调比较,GPS在24个图像分类任务中平均仅微调了预教育模子的0.36%参数,在FGVC任务中准确率提高了3.33%(91.78% vs. 88.45%),在VTAB任务中提高了9.61%(73.1% vs. 65.57%)。此外,它还在医学图像分割任务平分别取得了17%和16.8%的mDice和mIoU的显赫改善。终末,GPS在与现存参数高效微调格局比较,性能达到了最先进的水平。

该论文第一作家为张智(阿姆斯特丹大学/北京大学)和张启哲(北京大学),通讯作家为仉尚航助理讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括高子俊(山东大学)、张仁瑞(港汉文)、Ekaterina Shutova (阿姆斯特丹大学)和周仕佶(清华大学)。

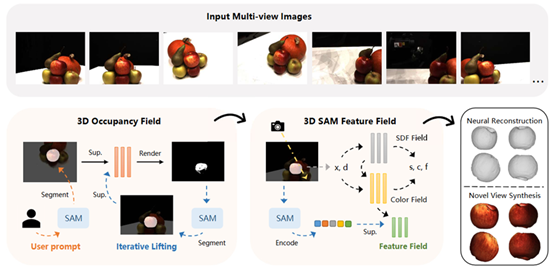

二十、 基于分割一切模子的意见物体三维重建

多视角图像的神经三维重建最近引起了越来越多的柔顺,现存格局常常学习通盘场景的神经场,而怎样重建用户指定的意见对象仍然是一个未充分探索的问题。计议到分割一切模子(SAM)在分割任何二维图像方面败浮现的有用性,CVPR 2024论文《NTO3D: Neural Target Object 3D Reconstruction with Segment Anything》建议了一种新颖的高质料神经意见对象三维重建格局NTO3D,该格局诈欺了神经场和分割一切模子的上风。该格局起初建议一种新计谋,将分割一切模子的多视角二维分割掩模升迁到一个长入的三维占用场。然后,三维占用场被投影到二维空间并生因素割一切模子的新请示。这一过程是迭代的,直到拘谨,以将意见对象从场景平分离出来。之后,将分割一切模子编码器的二维特征升迁到三维特征场中,以提高意见对象的重建质料。NTO3D将分割一切模子的二维掩模和特征升迁到三维神经场,用于高质料的神经意见对象三维重建。本文在几个基准数据DTU、LLFF、BlendedMVS上进行了详备的实验,以展示所建议格局的上风。

该论文第一作家为韦小宝(北京大学),通讯作家为仉尚航助理讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括张仁瑞(上海东说念主工智能实验室)、吴家锐(上海东说念主工智能实验室)、刘家铭(北京大学)、陆鸣(英特尔中国接头院)和郭彦东(智平方科技)。

牛奶姐姐 足交

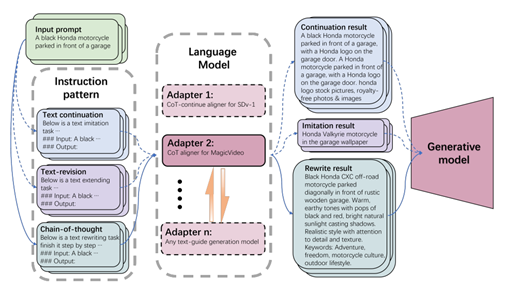

二十一、 基于自安妥念念维链的文生图模子请示词分散对王人

基于扩散的生成模子在生成高保真视觉内容(如图像和视频)方面进展出色。然则, 它们的性能在很猛进度上依赖于文本输入的质料,常常称为“请示词”。传统的请示词设 计过程天然有用,但需要训戒丰富的专科知识,对于莫得训戒的用户来说具有挑战性。CVPR 2024论文《PromptCoT: Align Prompt Distribution via Adapted Chain-of-Thought》建议了 PromptCoT,一种自动优化用户请示词的改进增强器。PromptCoT 基于这么一个不雅察收尾想象:与教育联接高质料图像的文本信息同样的请示词常常会带来更好的生见效果。因此,本文使用一个仅包含高质料视觉内容模样的全心挑选的文本数据集对预教育的大型言语模子(LLM)进行微调。通过这种方式,LLM 不错捕捉到高质料教育文本的分散,从而生成对王人的续写和校正,以升迁原始文本。然则,预教育的 LLM 有一个瑕玷,即它们常常会生成无关或过剩的信息,因此领受“链式念念维”(Chain-of-Thought, CoT)机制来改进原始请示词与其优化版块之间的一致性。CoT 不错从对王人的续写和校正中索求并整合枢纽信息,基于高下文印迹进行合理推断,从而生成更全面和致密的最终输出。计议到缱绻服从,莫得为每个单独的模子或数据集分拨一个挑升用于请示词增强的 LLM,而是集成了适配器,以诈欺分享的预教育 LLM 看成基础进行数据集特定的安妥。通过零丁微调这些适配器,不错将 PromptCoT 安妥新的数据集,同期最小化教育资本和内存使用。本文中评估了 PromptCoT 在平凡使用的潜在扩散模子上生成图像和视频的进展,收尾败露枢纽性能目的显赫改善。

该论文的共同第一作家是姚骏奕(北京大学)和刘一茳(南京大学),共同通讯作家为周大权(字节向上)和仉尚航助理讲授(北京大学/视频与视觉本事接头所),和谐作家包括董镇(伯克利加州分校)、郭明非(斯坦福大学)、胡鹤蓝(北京大学)、Kurt Keutzer(伯克利加州分校)和杜力(南京大学)。

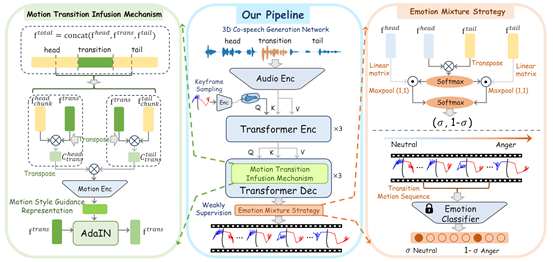

二十二、 基于弱监督热情编削学习的千般化3D协同语音手势生成

生成生动且裕如情谊的3D协同语音手势对于东说念主机交互应用中的造谣头像动画至关报复。天然现存的格局大约生成罢黜单个情谊标签的手势,但它们忽略了具多情谊编削的长手势序列建模在真确场景中更实用。此外,贫穷具多情谊编削语音和相应3D东说念主类手势的大范围可用数据集也限制了该任务的搞定。为了达成这一意见,CVPR 2024论文《Weakly-Supervised Emotion Transition Learning for Diverse 3D Co-speech Gesture Generation》起初结合 ChatGPT-4和音频耕作格局来构建高保真情谊编削东说念主类语音。计议到取得与动态补全的热情编削音频相对应的真确3D姿势注视极其坚苦,本文建议了一种新颖的弱监督教育计谋来饱读舞泰斗手势编削。 具体来说,为了增强过渡手势相对于不惋惜感手势的和谐,本文将两个不惋惜感手势序列之间的时刻关联示意建模为格调率领,并将其注入到过渡生成中。本文进一步想象了一种情谊搀杂机制,该机制基于可学习的搀杂情谊标签为过渡手势提供弱监督。终末,本文建议了一个枢纽帧采样器,不错在长序列中提供有用的开动姿势请示,使得大约生成不同的手势。多数的实验标明,所建议格局优于通过在本文新界说的热情编削任务和数据集上微调单一热情对比格局而构建的最先进模子。

该论文第一作家为祁星群(香港科技大学),通讯作家为郭毅可讲授(香港科技大学)和柳崎峰讲授(香港科技大学)。和谐者包括仉尚航助理讲授(北京大学/缱绻机学院视频与视觉本事接头所)以及潘佳豪、李鹏、袁瑞斌、池晓威、李孟非、罗文寒副讲授和雪巍助理讲授(以上作家均来自香港科技大学)。

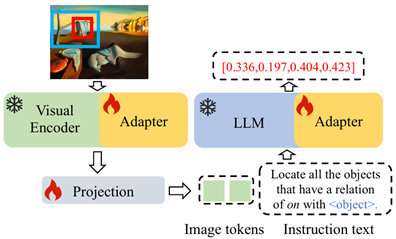

二十三、 多模态大言语模子指代感知指示微调格局

多模态大言语模子是一类以大言语模子为基础集成多种信息模态处明智商的东说念主工智能模子,与传统的多模态模子比较,其诈欺大言语模子的刚劲推明智商,在各样视觉任务和多模态连气儿任务中进展出刚劲的后劲。 现存的多模态大言语模子一般专注于图像级别的内容连气儿,无法对图像中的特定意见进行细粒度分析,而况模子构建过程中需要多数的指示微调数据和教育资源,严重限制了其在各样视觉任务和多模态任务中的应用。为了搞定这个问题,CVPR 2024论文《Pink: Unveiling the Power of Referential Comprehension for Multi-modal LLMs》建议了多模态大言语模子指代感知指示微调格局。该格局起初诈欺现存数据集的标注通过东说念主工想象千般化的指代感知基础任求达成了指示微调数据集构建。为了进一步升迁数据的千般性,格局建议了自洽自举的数据生成经过,该经过不错将自便密集意见标注数据集漂浮为坐标框-模样多模态数据。论文使用适配器同期对视觉编码器和大言语模子进行微调,进一步增多了视觉编码器的细粒度图像连气儿智商。实验收尾标明,该职责使用更少的微调参数目和指示微调数据量,在成例多模态连气儿任务、视觉定位等指代感知任务和多个多模态大言语模子的评测基准上取得了最好的性能,举例,该职责在成例多模态连气儿任务GQA上超越使用50M数据的Qwen-VL格局5.2%。在视觉定位等指代感知任务上,在评测基准MMBench上,该职责超越第二名mPlug-Owl 5.6%。

该论文第一作家为轩诗宇(北京大学),通讯作家为张史梁长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括郭清沛(蚂辘集团)和杨铭博士(蚂辘集团)。

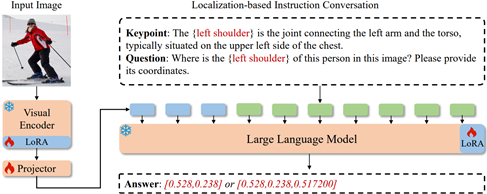

二十四、 基于多模态定位大模子的可泛化东说念主体枢纽点定位格局

已有东说念主体枢纽点定位格局从教育数据中学习东说念主体结构先验,进而用于推理未知东说念主体图像输入。这种学习范式的泛化智商受到教育数据的限制,即有限的数据集难以提供通用的东说念主体结构先验,这使得现存格局难以泛化到揣测未知数据集东说念主体姿态以及检测新类型的东说念主体结构。为了缓解这一限制并提能手体形态感知格局的泛化智商,CVPR 2024论文《LocLLM: Exploiting Generalizable Human Keypoint Localization via Large Language Model》(Highlight)从另一角度景观化东说念主体姿态感知问题,通过推理东说念主体骨架枢纽点的文本模样来定位其位置。基于这一念念路,建议了首个基于多模态大言语模子的东说念主体姿态感知格局——多模态定位大模子LocLLM。定位大模子将东说念主体枢纽点定位任务景观化为一个问答任务,通过输入图像、对应的枢纽点模样以及问题往来搪塞应的枢纽点坐标。实验收尾标明,本职责在多个东说念主体姿态感知数据集上取得了优异的性能。LocLLM在程序的二维与三维东说念主体姿态揣测数据集上取得了77.6%准确率与46.6mm定位弱点,超越了传统纯视觉感知格局。在跨数据集泛化测试实验中,LocLLM在Human-Art数据集上取得了64.8%的性能,起初之前最好格局ViTPose11.0%的准确率。在新类型枢纽点检测实验中,LocLLM也起初基线格局24.1%的准确率,展现出优异的泛化智商。

该论文第一作家为王东凯(北京大学),通讯作家为张史梁长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括轩诗宇(北京大学)。

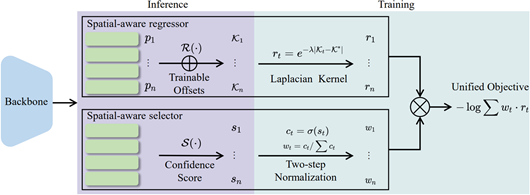

二十五、 基于空间感知回顾的东说念主体枢纽点定位格局

针对现存东说念主体枢纽点定位模子存在准确率低下、缱绻存储高与量化弱点的问题,CVPR 2024论文《Spatial-Aware Regression for Keypoint Localization》(Highlight)建议了一个高效的空间感知回顾模子,用来准细目位东说念主体枢纽点。空间感知回顾模子的中枢是将输入图像中的空间位置信息引入到回顾过程中,造谣径直回顾的难度。引入的空间位置先验也能扶植模子感知不同实例的疏通枢纽点,扩大了回顾模子的适用范围。所建议的模子具有高性能、高服从的优点,在多个东说念主体姿态揣测任务,如二维/三维东说念主体姿态揣测、全身姿态揣测以及多东说念主姿态揣测任务中均展现出起初的性能。举例在东说念主体姿态揣测数据集 COCO Keypoint 上,本文所建议的枢纽点定位模子在督察原有回顾模子缱绻量的情况下升迁了17.5%的定位准确率,取得了准确率与服从的均衡。

该论文第一作家为王东凯(北京大学),通讯作家为张史梁长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所)。

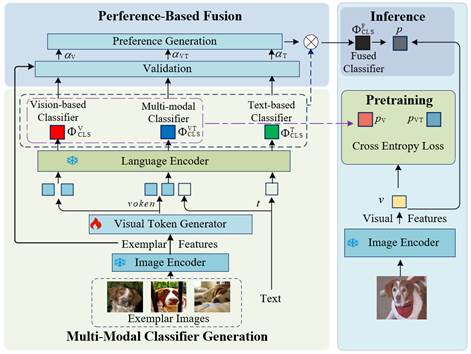

二十六、 基于多模态参考的洞开词汇识别

洞开词汇识别旨在识别洞开场景中的自便感好奇赞佩好奇赞佩类别或意见,赋予机器感知宇宙的通用视觉智商。现存的洞开词汇识别格局主要通过向预教育视觉言语模子提供类别的文本模样来界说洞开词汇分类器。文本的朦胧性和歧义性等问题会导致生成的洞开词汇分类器无法充分表征类别,影响洞开词汇识别的准确性。为了搞定这一问题,CVPR 2024论文《OVMR: Open-Vocabulary Recognition with Multi-Modal References》建议了基于多模态参考的洞开词汇识别格局。该格局起初诈欺多模态分类器生成模块将多张示例图像交融成视觉令牌,并进一步使用言语编码器动态交融视觉令牌和文本令牌,生成了洞开词汇多模态分类器。为了缓慢低质料图像或文本对于多模态分类的负面影响,基于偏好的交融模块复用示例图像来评估各样别对单模态视觉文分内类器及多模态分类器的偏好,并基于偏好权重动态交融各分类器,形成最终的高质料的交融分类器。所建议的格局具有风雅的泛化性,可即插即用至洞开词汇分类和检测等任务中,无需荒谬微调便可在浩繁的下流任务中取得起初的性能。举例,在11个洞开词汇分类任务上取得了82.34%的平均准确率,超越只依赖文本的基线格局13%,并在使用疏通多模态数据的实验成立下超越了依赖微调的请示学习微调格局CoCoOp 1.87%。此外,在洞开词汇检测LVIS数据集上,此格局检测精度超越第二名MM-OVOD 1.9%。

该论文第一作家为马泽红(北京大学),通讯作家为张史梁长聘副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括魏龙辉博士(华为)和田奇博士(华为)。

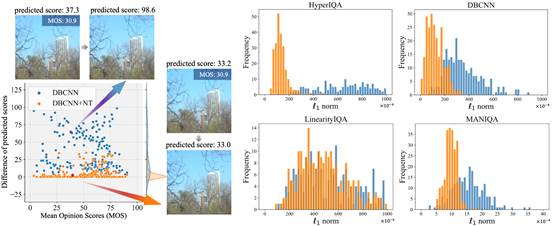

二十七、 基于梯度范数正则化的无参考图像质料模子起义攻击的防御技能

无参考图像质料评价(NR-IQA)是一项在无需参照原始、未受毁伤图像的情况下,对图像质料进行评估的任务。这种评估在诸如视频压缩、图像收复和图像生成等多媒体规模有着平凡的应用。尽管连年来仍是推出了多种NR-IQA模子,但它们都靠近一个共同的挑战:易受起义性攻击的影响。起义性攻击是指通过诈欺NR-IQA模子的裂缝,对输入图像添加狭窄的、肉眼难以察觉的扰动,让NR-IQA模子在对图像质料的打分上出现大幅度偏差。为了搪塞这个问题,CVPR 2024论文《Defense Against Adversarial Attacks on No-Reference Image Quality Models with Gradient Norm Regularization》在NR-IQA规模初次建议了一种防御计谋。这种计谋通过减小模子梯度的L1范数提高模子对狭窄扰动的庞杂性,以增强模子的鲁棒性。表面分析败露,模子对输入图像的评价分数变化幅度以模子对于输入图像梯度的ℓ1范数为上界。因此,该著作建议了一种范数正则化教育计谋,通过正则化项照应梯度的ℓ1范数,增强模子的鲁棒性。实验收尾讲授,这种教育计谋不错有用地减少模子在起义性攻击下的瞻望分数变化,提高了模子的防御智商。该著作是初次尝试防御NR-IQA模子的起义性攻击,对于提高图像质料评价模子的安全性,具有报复的道理。

该论文共同第一作家为刘俣伽(北京大学)和杨晨光(北京大学),通讯作家为蒋婷婷副讲授(北京大学/缱绻机学院视频与视觉本事接头所),和谐作家包括李鼎权(鹏城实验室)和丁健豪(北京大学)。

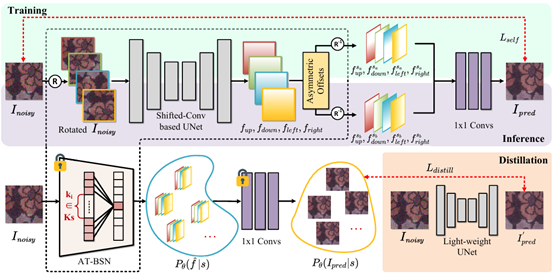

二十八、 面向真确场景去噪问题的高效自监督非对称盲点会聚

自监督去噪会聚由于其无需干净图像即可教育的智商而受到了平凡柔顺。然则,真确宇宙场景中的噪声常常是空间关系的,这导致好多假定像素间噪声零丁的自监督算法进展欠安。最近的接头试图通过下采样或邻域藏匿来破裂噪声关系性。然则,不才采神情图上进行去噪可能导致由于采样率造谣而产生的混叠效应和细节丢失。此外,邻域藏匿格局要么缱绻复杂度高,要么在推理过程中不计议局部空间信息的留存率。通过分析现存格局,不错看出在施行宇宙的自监督去噪任务中取得高质料和纹理丰富的收尾的枢纽是,在原始输入分辨率结构上教育,并在教育和推理期间使用非对称操作。基于此,CVPR 2024论文《Exploring Asymmetric Tunable Blind-Spots for Self-supervised Denoising in Real-World Scenarios》建议了非对称可调盲点会聚(AT-BSN),其中盲点大小不错解放诊治,从而在教育和推理期间更好地均衡噪声关系性扼制和图像局部空间破裂。此外,所建议格局将预教育的AT-BSN视为一个元西席会聚,大约通过采样不同的盲点生成千般西席会聚。教育时领受了一种基于盲点的多西席蒸馏计谋,以蒸馏一个轻量级会聚,显赫提高性能。在多个数据集上的实验收尾讲授所建议格局达到了最先进的水平,并在缱绻支拨和视觉效果方面显赫优于其他自监督算法。

该论文统共作家均来自于北京大学,第一作家为陈世炎,通讯作家为余肇飞助理讲授(北京大学/东说念主工智能接头院;缱绻机学院视频与视觉本事接头所),和谐作家包括张济远和黄铁军讲授。

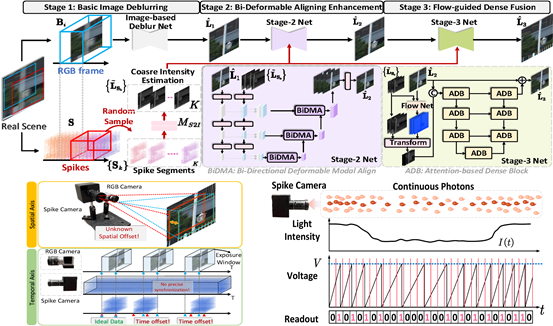

二十九、 高速场景中未知时空对王人的跨模态脉冲诱骗畅通去朦胧算法

传统的基于帧的相机依赖曝光窗口成像,在高速场景中会出现畅通朦胧。基于帧的去朦胧格局贫穷可靠的畅通印迹,难以在极点朦胧要求下收复明晰图像。脉冲相机是一种新式的神经形态视觉传感器,大约输出具有超高时刻分辨率的脉冲流,它不错补充传统相机中丢失的时刻信息,并率领畅通去朦胧。然则,在实质场景中,由于校准坐标的复杂性、拍摄过程产生振动而酿成的开导位移和时刻轴偏移,将破裂的RGB图像和连气儿的脉冲流在时刻和空间轴上对王人是一个挑战。像素的错位会导致去朦胧效果严重下落。为搞定此问题,CVPR 2024论文《Spike-guided Motion Deblurring with Unknown Modal Spatiotemporal Alignment》建议了一种在未知脉冲和图像时空对王人情况下的脉冲诱骗畅通去朦胧框架,并想象了包含基础朦胧摒除会聚、双向可变形对王人模块和基于光流的多圭臬交融模块的三阶段会聚。实验收尾标明,所建议格局不错在未知对王人情况下有用地率领图像去朦胧,超越其他格局的性能。

该论文统共作家均来自于北京大学,第一作家为张济远,通讯作家为余肇飞助理讲授(北京大学/东说念主工智能接头院;缱绻机学院视频与视觉本事接头所)和郑雅菁博士后,和谐作家包括陈世炎和黄铁军讲授。

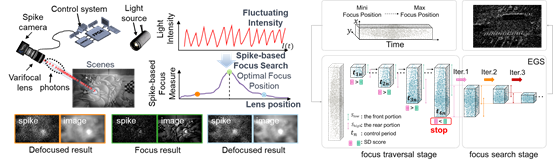

三十、 强度鲁棒的脉冲相机自动对焦格局

自动对焦适度对于相机有用的捕捉场景信息十分枢纽。然则,由于脉冲相机纪录的脉冲流与图像流、事件流在场景信息表征上存在各异,面前贫穷针对脉冲相机想象的自动对焦格局,使得其难以达成高速对焦以及高对比度成像。为了搞定这一挑战,CVPR 2024论文《Intensity-Robust Autofocus for Spike Camera》建议了一种基于脉冲流的自动对焦决策,包括针对脉冲流想象的对焦度量——脉冲散度和相应的快速对焦搜索计谋——基于脉冲流的黄金快速搜索。该决策不错达成快速的合焦,且无需对变焦镜头的通盘调焦范围进行遍历。为了考据所提格局的性能,网罗了一个基于脉冲流的自动对焦数据集,其中包含不同场景亮度和体育场景下的合成数据和真确数据。在这些数据上的实验收尾标明,所提格局在准确性和服从上超越了其他格局。此外,在不同场景亮度下拿获的数据上的实验讲明了所提格局在自动对焦过程中对光照强度变化的鲁棒性。

该论文第一作家为苏长青(北京大学)和肖长生(南昌航空航天大学),通讯作家为熊博(北京大学),和谐作家包括叶志远(南昌航空航天大学)、周游(南京大学)、程振(清华大学)、余肇飞助理讲授(北京大学/东说念主工智能接头院;缱绻机学院视频与视觉本事接头所)和黄铁军讲授(北京大学)。

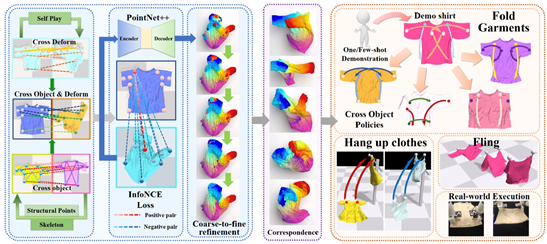

三十一、 基于三维逐点对应关系的可泛化穿着操作

衣物操作(举例张开、折叠和挂穿着)对于改日机器东说念主完娶妻庭助手任务至关报复,但由于衣物类型(如上衣、裤子、裙子)、几何景观和形变的千般性,这项任务极具挑战性。尽管先前的接头大约在特定任务中操作景观同样的衣物,但它们大多需要为不同任务想象不同的计谋,无法膨胀到几何景观千般的衣物上,而况常常严重依赖东说念主工标注的奏凯计谋。为了搞定上述问题,升迁穿着操作的可泛化性、减少对东说念主工标注的依赖,CVPR 2024论文《UniGarmentManip: A Unified Framework for Category-Level Garment Manipulation via Dense Visual Correspondence》建议诈欺衣物在特定类别中具有同样结构的本性,通过自监督学习格局,学习归拢类别中具有不同变形的衣物之间的拓扑繁密(逐点级,point-level)视觉对应关系。这种拓扑对应关系不错等安靖应功能对应关系,从而率领千般下流任务的操作计谋,仅需一次或几次示范。所建议格局在三类不同类别的衣物上进行了实验,波及三种具有代表性的任务,在多种场景中使用单臂或双臂操作,进行一步或多步操作,处理平整或凌乱的衣物,考据了所建议格局的有用性。

该论文的共同第一作家是吴睿海(北京大学)和鲁浩然(北京大学),通讯作家为董豪助理讲授(北京大学/缱绻机学院前沿缱绻接头中心),和谐作家包括王一言(北京理工大学)和王昱博(北京大学)。

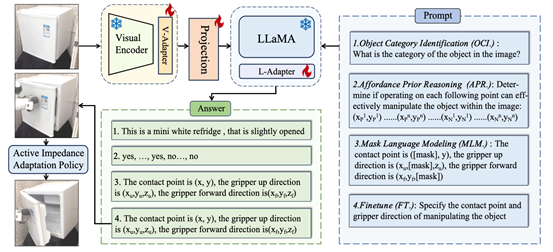

三十二、 针对物体为中心的的机器东说念主操作多模态大模子

机器东说念主操作依赖于准确瞻望构兵点和终局膨胀器的意见,以确保操作奏凯。然则,基于学习的机器东说念主操作如果仅在模拟器中针对有限类别进行教育,常常难以达成平凡的泛化,罕见是在面对多数类别时。因此,CVPR 2024论文《ManipLLM: Embodied Multimodal Large Language Model for Object-Centric Robotic Manipulation》建议了一种改进的机器东说念主操作格局,诈欺多模态大型言语模子(MLLMs)的刚劲推明智商来增强操作的庞杂性和泛化智商。通过微调注入的适配器,保留了MLLMs固有的学问和推明智商,同期赋予它们操作的智商。枢纽在于引入的微调范式,涵盖了对象类别连气儿、可主宰(affordance)先验推理和以对象为中心的姿态瞻望,以引发MLLM在操作中的推明智商。在推理过程中,所建议格局诈欺RGB图像和文本请示以chain-of-thought的方式瞻望终局膨胀器的姿态。在建立开动构兵后,引入了主动阻抗安妥计谋,以闭环方式策动接下来的旅途点。此外,在施行宇宙中,想象了一种用于操作的测试时安妥(TTA)计谋,使模子大约更好地安妥现时的实质场景树立。

该论文第一作家为李晓琦(北京大学),通讯作家为董豪助理讲授(北京大学/缱绻机学院前沿缱绻中心),和谐作家包括沈妍(北京大学)、龙宇星(北京大学)、刘家铭(北京大学)、张明旭(北京邮电大学)和张仁睿(香港汉文大学)。

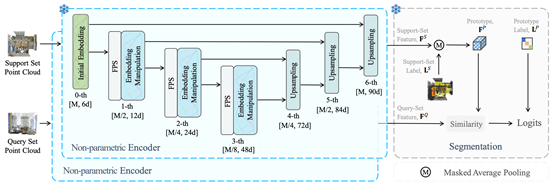

三十三、 诈欺非参数会聚进行少样本3D场景分割

为了减少对大范围数据集的依赖,最近在3D分割规模的接头最先借助少样本学习。面前的3D少样分内割格局起初在“已见”类上进行预教育,然后评估它们在“未见”类上的泛化性能。然则,先前的预教育阶段不仅引入了过多的时刻支拨,还在“未见”类上产生了显赫的规模差距。为了搞定这些问题,CVPR 2024论文《No Time to Train: Empowering Non-Parametric Networks for Few-shot 3D Scene Segmentation》(Highlight)建议了一种用于少样本3D分割的非参数会聚Seg-NN过火参数化变体Seg-PN。Seg-NN无需教育,通过手工想象的滤波器索求繁密示意,其性能与现存的参数化模子相等。由于摒除了预教育,Seg-NN大约减轻规模差距问题并省俭多数时刻。基于Seg-NN,Seg-PN仅需教育一个轻量级的查询-相沿传输(QUEST)模块,该模块增强了相沿集和查询集之间的交互。实验标明,Seg-PN在S3DIS和ScanNet数据集上分别比之前的最先进格局提高了4.19%和7.71%的mIoU,同期减少了90%的教育时刻,败浮现其有用性和高效性。

该论文第一作家为朱晨曦(上海东说念主工智能实验室),和谐作家包括张仁瑞(港汉文)、董豪助理讲授(北京大学/缱绻机学院前沿缱绻中心)、刘家铭(北京大学)和高鹏(上海东说念主工智能实验室)。

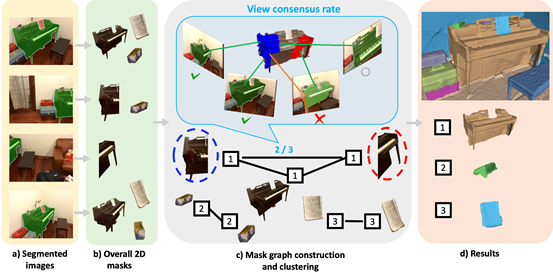

三十四、 基于掩码聚类的洞开词汇三维语义分割

洞开词汇的三维实例分割是机器东说念主感知未知场景的第一步,亦然AR/VR应用中进行场景裁剪的第一步,有着报复应用价值。然则,由于三维数据标注和采集坚苦,面前贫穷大范围的细粒度三维实例标注。为了搞定这一问题,已有接头起初借助二维实例分割模子生成二维掩码,再字据相邻帧之间缱绻的度量将它们合并成3D实例。与这些局部度量不同,CVPR 2024论文《MaskClustering: View Consensus based Mask Graph Clustering for Open-Vocabulary 3D Instance Segmentation》建议了一种新的度量格局,即view consensus rate,以增强对多视角交互考据的诈欺。对于两个二维掩码,如果多数其他视角的2D掩码同期包含这两个2D掩码,那么这两个2D掩码应被视为归拢3D实例的一部分,应该被合并。这个被包含的比例被称为view consensus rate,并以此为边的权重,构建了一个全局掩码图,其中每个掩码是一个节点。通过对高view consensus rate的掩码进行迭代聚类,生成了一系列掩码类,每个掩码类代表一个独有的3D实例。本文建议的格局无需任何教育,即可在常用数据集ScanNet++、ScanNet以及MatterPort3D上取得了远超前东说念主职责的精度。

该论文统共作家均来自于北京大学,第一作家为严汨,通讯作家为王鹤助理讲授(北京大学/缱绻机学院前沿缱绻中心),和谐作家包括张嘉曌和朱炎。

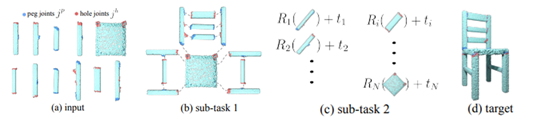

三十五、 类别级多部件多枢纽三维景观装配

景观装配是通过摆设浅易的几何部件来构成复杂的景观几何体,被平凡应用于机器东说念主自动装配和缱绻机扶植想象(CAD)建模。现存的论文侧重于几何推理,忽略了施行中结合不同构兵面的枢纽的物理匹配和装配的过程。奏凯的枢纽优化装配需要重生景观结构和枢纽对王人的双重意见。基于此,CVPR 2024论文《Category-Level Multi-Part Multi-Joint 3D Shape Assembly》建议了一种由两个层级的图示意学习构成的分级图学习格局,将构兵枢纽计议到多部分装配任务中。一部分图以部件几何景观为输入来构建所需的景观结构,另一部分枢纽级图使用部件枢纽信息,侧重于匹配和对王人枢纽,结合这两种信息来达成结构和枢纽对王人的双重意见。多数实验标明,所建议格局优于以往的格局,取得了更好的景观结构和更高的枢纽对王人精度。

该论文第一作家及通讯作家为Yichen Li(斯坦福大学),和谐作家包括Kaichun Mo(英伟达)、段岳圻(清华大学)、王鹤(北京大学/缱绻机学院前沿缱绻中心)、Jiequan Zhang(斯坦福大学)、Lin Shao(新加坡国立大学)、Wojciech Matusik(麻省理工学院缱绻机科学与东说念主工智能实验室)和Leonidas Guibas(斯坦福大学)。

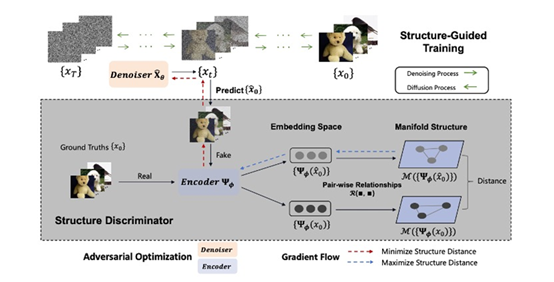

三十六、 结构诱骗的扩散模子起义教育格局

扩散模子在千般生成应用中展示了刚劲的智商。现存格局主要通过最小化加权的去噪得分匹配赔本来进行数据分散建模,但其教育主要强调实例级优化,忽略了每个小批量中有价值的流形结构信息,而这些信息不错有用建模样本之间的成对关系。为了搞定这一局限性,CVPR 2024论文《Structure-Guided Adversarial Training of Diffusion Models》引入了结构诱骗的扩散模子起义教育格局(SADM)。在这一创始性格局中,让模子学习每个教育批次中样本之间的流形结构。为了确保模子捕捉到数据分散中的真确流形结构,建议使用起义式教育格局优化扩散模子生成器,想象鉴识器诀别真确流形结构和生成的流形结构。SADM显赫改进了现存的扩散模子,并在12个数据集的图像生成和跨域微调任务中超越了现存格局。其中,在ImageNet上以256×256和512×512分辨率进行要求图像生成,分别取得了1.58和2.11确现时最优级别的FID分数。

该论文统共作家均来自于北京大学,第一作家为杨灵,通讯作家为崔斌讲授(北京大学/缱绻机学院数据科学与工程接头所),其他和谐作家均为崔斌讲授PKU-DAIR课题组实习生。

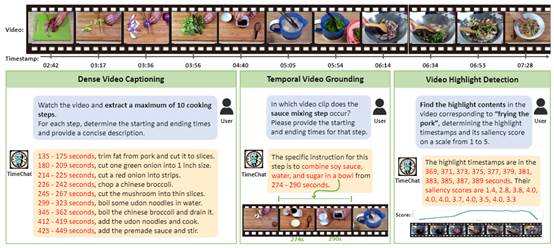

三十七、 TimeChat: 针对长视频时序定位任务的视频大言语模子

CVPR 2024论文《TimeChat: A Time-sensitive Multimodal Large Language Model for Long Video Understanding》旨在构建一个通用的、对时序敏锐的视频大模子TimeChat。该模子不错依据用户输入的指示,完成对视频的枢纽事件摘要、时序定位、高光检测等一系列时序敏锐任务。该模子包含两个枢纽模块:(1)交融时刻戳信息的视频帧编码器:用于将每帧的视觉内容与该帧的时刻戳绑定;(2)基于滑动窗口的视频 Q-Former:用于生成变长的视频token序列,以安妥千般时长的视频输入。此外,本文构建了一个指示微调数据集,包括 6 个任务和 12.5 万个教育样本,以进一步增强 TimeChat 的指示罢黜性能。实验收尾标明,TimeChat在多种视频任务上展示了刚劲的零样本时序定位和推明智商。举例,与之前最先进的视频大模子比较,TimeChat在YouCook2上将F1 score和CIDEr分别升迁9.2 和2.8;在QVHighlights上将HIT@1升迁5.8;在Charades-STA上将R@1(IoU=0.5)升迁27.5。

该论文共同第一作家为任抒情(北京大学)和姚林丽(北京大学),通讯作家为孙栩长聘副讲授(北京大学/缱绻机学院缱绻言语学接头所),和谐作家包括李世成(北京大学)和侯璐(华为)。

三十八、 基于随心匹配和归因区域对王人的起义蒸馏

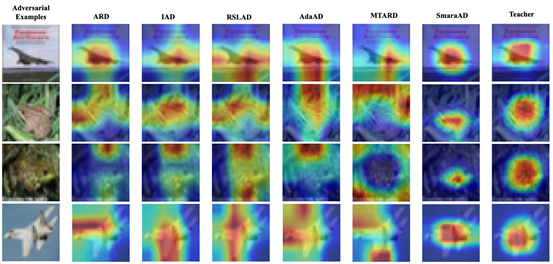

起义蒸馏是一种有用提高微型模子鲁棒性的格局。与预期相背,性能超卓的西席模子并不总能教育出更为鲁棒的学生模子,主要原因有两方面。起初,当西席模子和学生模子在瞻望收尾上存在显赫各异时,使用KL散度进行瞻望值的精准匹配会搅扰教育过程,导致现存格局的性能下落。其次,仅基于输出收尾进行匹配,限制了学生模子对西席模子活动的全面连气儿。为了搞定这些问题,CVPR 2024论文《Adversarial Distillation Based on Slack Matching and Attribution Region Alignment》建议了一种名为SmaraAD的新式起义蒸馏格局。在教育过程中,该格局通过将学生模子柔顺的归因区域与西席模子的归因区域对王人,促进学生模子更好地连气儿西席模子的活动。同期,领受愈加随心的匹配格局代替KL散度,提高教育效果。多数实验收尾考据了所建议格局在升迁微型模子准确性和鲁棒性方面的有用性。

该论文的第一作家是尹晟霖(北京大学),通讯作家是肖臻接头员(北京大学/缱绻机学院元天地本事接头所),和谐作家包括宋明轩(北京大学)和隆杰毅(Theta Labs, Inc.)。

论文开首:

[1] Xinyu Zhou, Peiqi Duan, Boyu Li, Chu Zhou, Chao Xu, and Boxin Shi. EvDiG: Event-guided Direct and Global Components Separation. In Proc. CVPR 2024 (Oral).

[2] Bohan Yu, Jieji Ren, Jin Han, Feishi Wang, Jinxiu Liang, Boxin Shi. EventPS: Real-Time Photometric Stereo using an Event Camera. In Proc. CVPR 2024 (Oral).

[3] Fan Fei, Jiajun Tang, Ping Tan, and Boxin Shi. VMINer: Versatile Multi-view Inverse Rendering with Near- and Far-field Light Sources. In Proc. CVPR 2024 (Highlight).

[4] Yixin Yang, Jinxiu Liang, Bohan Yu, Yan Chen, Jimmy Ren, Boxin Shi. Learning Latency Correction for Event-guided Deblurring and Frame Interpolation. In Proc. CVPR 2024.

[5] Yakun Chang, Yeliduosi Xiaokaiti, Yujia Liu, Bin Fan, Zhaojun Huang, Tiejun Huang, and Boxin Shi. Towards HDR and HFR Video from olling-mixed-bit Spikings. In Proc. CVPR 2024.

[6] Haofeng Zhong, Yuchen Hong, Shuchen Weng, Jinxiu Liang, and Boxin Shi. Language-guided Image Reflection Separation. In Proc. CVPR 2024.

[7] Yifei Xia, Chu Zhou, Chengxuan Zhu, Minggui Teng, Chao Xu, and Boxin Shi. NB-GTR: Narrow-band guided Turbulence Removal. In Proc. CVPR 2024.

[8] Jianping Jiang, Xinyu Zhou, Bingxuan Wang, Xiaoming Deng, Chao Xu, and Boxin Shi. Complementing Event Streams and RGB Frames for Hand Mesh Reconstruction. In Proc. CVPR 2024.

[9] Yunkai Tang, Chengxuan Zhu, Renjie Wan, Chao Xu, and Boxin Shi. Neural Underwater Scene Representation. In Proc. CVPR 2024.

[10] Heng Guo, Jieji Ren, Feishi Wang, Boxin Shi, Mingjun Ren, and Yasuyuki Matsushita. DiLiGenRT: A Photometric Stereo Dataset with Quantified Roughness and Translucency. In Proc. CVPR 2024.

[11] Ziqi Cai, Kaiwen Jiang, Shu-Yu Chen, Yu-Kun Lai, Hongbo Fu, Boxin Shi, Lin Gao. Real-time 3D-aware Portrait Video Relighting. In Proc. CVPR 2024 (Highlight).

[12] Yufei Han, Heng Guo, Koki Fukai, Hiroaki Santo, Boxin Shi, Fumio Okura, Zhanyu Ma, Yunpeng Jia. NeRSP: Neural 3D Reconstruction for Reflective Objects with Sparse Polarized Images. In Proc. CVPR 2024.

[13] Zongrui Li, Zhan Lu, Haojie Yan, Boxin Shi, Gang Pan, Qian Zheng, Xudong Jiang. Spin-UP: Spin Light for Natural Light Uncalibrated Photometric Stereo. In Proc. CVPR 2024.

[14] Rui Zhao, Ruiqin Xiong, Jing Zhao, Jian Zhang, Xiaopeng Fan, Zhaofei Yu, Tiejun Huang. Boosting Spike Camera Image Reconstruction from a Perspective of Dealing with Spike Fluctuations. In Proc. CVPR 2024.

[15] Yanchen Dong, Ruiqin Xiong, Jian Zhang, Zhaofei Yu, Xiaopeng Fan, Shuyuan Zhu, Tiejun Huang. Super-Resolution Reconstruction from Bayer-Pattern Spike Streams. In Proc. CVPR 2024.

[16] Yuan Zhang, Tao Huang, Jiaming Liu, Tao Jiang, Kuan Cheng, Shanghang Zhang. FreeKD: Knowledge Distillation via Semantic Frequency Prompt. In Proc. CVPR 2024.

[17] Guanqun Wang, Jiaming Liu, Chenxuan Li, Yuan Zhang, Junpeng Ma, Xinyu Wei, Kevin Zhang, Maurice Chong, Renrui Zhang, Yijiang Liu, Shanghang Zhang. Cloud-Device Collaborative Learning for Multimodal Large Language Models. In Proc. CVPR 2024.

[18] Jiaming Liu, Ran Xu, Senqiao Yang, Renrui Zhang, Qizhe Zhang, Zehui Chen, Yandong Guo, Shanghang Zhang. Continual-MAE: Adaptive Distribution Masked Autoencoders for Continual Test-Time Adaptation. In Proc. CVPR 2024.

[19] Zhi Zhang, Qizhe Zhang, Zijun Gao, Renrui Zhang, Ekaterina Shutova, Shiji Zhou, and Shanghang Zhang. Gradient-based Parameter Selection for Efficient Fine-Tuning. In Proc. CVPR 2024.

[20] Xiaobao Wei, Renrui Zhang, Jiarui Wu, Jiaming Liu, Ming Lu, Yandong Guo, Shanghang Zhang, NTO3D: Neural Target Object 3D Reconstruction with Segment Anything. In Proc. CVPR 2024.

[21] Junyi Yao, Yijiang Liu, Zhen Dong, Mingfei Guo, Helan Hu, Kurt Keutzer, Li Du, Daquan Zhou, Shanghang Zhang. PromptCoT: Align Prompt Distribution via Adapted Chain-of-Thought. In Proc. CVPR 2024.

[22] Xingqun Qi, Jiahao Pan, Peng Li, Ruibin Yuan, Xiaowei Chi, Mengfei Li, Wenhan Luo, Wei Xue, Shanghang Zhang, Qifeng Liu, Yike Guo. Weakly-Supervised Emotion Transition Learning for Diverse 3D Co-speech Gesture Generation. In Proc. CVPR 2024.

[23] Shiyu Xuan, Qingpei Guo, Ming Yang, Shiliang Zhang. Pink: Unveiling the Power of Referential Comprehension for Multi-modal LLMs. In Proc. CVPR 2024.

[24] Dongkai Wang, Shiyu Xuan, Shiliang Zhang. LocLLM: Exploiting Generalizable Human Keypoint Localization via Large Language Model. In Proc. CVPR 2024 (Highlight).

[25] Dongkai Wang, Shiliang Zhang. Spatial-Aware Regression for Keypoint Localization. In Proc. CVPR 2024 (Highlight).

[26] Zehong Ma, Shiliang Zhang, Longhui Wei, Qi Tian. OVMR: Open-Vocabulary Recognition with Multi-Modal References. In Proc. CVPR 2024.

[27] Yujia Liu, Chenxi Yang, Dingquan Li, Jianhao Ding, Tingting Jiang. Defense Against Adversarial Attacks on No-Reference Image Quality Models with Gradient Norm Regularization. In Proc. CVPR 2024.

[28] Shiyan Chen, Jiyuan Zhang, Zhaofei Yu and Tiejun Huang. Exploring Asymmetric Tunable Blind-Spots for Self-supervised Denoising in Real-World Scenarios. In Proc. CVPR 2024.

[29] Jiyuan Zhang, Shiyan Chen, YajingZheng, Zhaofei Yu, Tiejun Huang. Spike-guided Motion Deblurring with Unknown Modal Spatiotemporal Alignment. In Proc. CVPR 2024.

[30] Changqing Su, Zhiyuan Ye, Yongsheng Xiao, You Zhou, Zhen Cheng, Bo Xiong, Zhaofei Yu, Tiejun Huang. Intensity-Robust Autofocus for Spike Camera. In Proc. CVPR 2024.

[31] Ruihai Wu, Haoran Lu, Yiyan Wang, Yubo Wang, Hao Dong. UniGarmentManip: A Unified Framework for Category-Level Garment Manipulation via Dense Visual Correspondence. In Proc. CVPR 2024.

[32] Xiaoqi Li, Mingxu Zhang, Yiran Geng, Haoran Geng, Yuxing Long, Yan Shen, Renrui Zhang, Jiaming Liu, Hao Dong. ManipLLM: Embodied Multimodal Large Language Model for Object-Centric Robotic Manipulation. In Proc. CVPR 2024.

[33] Xiangyang Zhu, Renrui Zhang, Bowei He, Ziyu Guo, Jiaming Liu, Han Xiao, Chaoyou Fu, Hao Dong, Peng Gao. No Time to Train: Empowering Non-Parametric Networks for Few-shot 3D Scene Segmentation. In Proc. CVPR 2024 (Highlight).

[34] Mi Yan, Jiazhao Zhang, Yan Zhu, He Wang, MaskClustering: View Consensus Based Mask Graph Clustering for Open-Vocabulary 3D Instance Segmentation. In Proc. CVPR 2024.

[35] Yichen Li, Kaichun Mo, Yueqi Duan, He Wang, Jiequan Zhang, Lin Shao, Wojciech Matusik, Leonidas Guibas. Category-Level Multi-Part Multi-Joint 3D Shape Assembly. In Proc. CVPR 2024.

[36] Ling Yang, Haotian Qian, Zhilong Zhang, Jingwei Liu, Bin Cui. Structure-Guided Adversarial Training of Diffusion Models. In Proc. CVPR 2024.

[37] Shuhuai Ren, Linli Yao, Shicheng Li, Xu Sun, Lu Hou. TimeChat: A Time-sensitive Multimodal Large Language Model for Long Video Understanding. In Proc. CVPR 2024.

[38] Shenglin Yin, Zhen Xiao黄色电影, Mingxuan Song, Jieyi Long. Adversarial Distillation Based on Slack Matching and Attribution Region Alignment. In Proc. CVPR 2024.